Eliza Natasa Artinyan

Deloitte Türkiye

Kurumsal Risk Hizmetleri

Kıdemli Danışman

Veri Analizi - Veri Kalitesi ve Bütünlüğü

Veri analizi sürecinde istatistiksel yöntem ve tekniklerin uygulanması, bilgisayarın hayatımızda

olmadığı ya da bu yöntem ve tekniklerin kullanımına yönelik yazılımların üretilmediği dönemlerde,

özellikle sosyal bilimciler için teorik istatistik bilgisi gerektiren bir aşama olup bir hayli zaman

almaktaydı.

Günümüzde bilgisayar kullanımının yaygınlaşmasıyla, her alanda olduğu gibi bu alanda da paket

programların piyasaya sürülmesi veri analizi sürecini oldukça kolaylaştırmaktadır. Gün geçtikçe

üretici firmaların rekabetçi bir anlayışla bu alandaki programları geliştirip daha yeni sürümlerle ve

daha profesyonel yazılımlarla karşımıza çıkması, araştırmacıların üzerinden büyük bir yük almakta ve

kısa bir süre içerisinde istenilen istatistiksel analizlerin yapılmasına olanak sağlamaktadır.

Peki veri nedir? Veri, nesneler ve nesnelerin niteliklerinden oluşan bir kümedir. Örnek olarak kayıt

(record), varlık (entity), örnek (sample, instance), nesne için kullanılabilir. Nitelik (attribute) bir

nesnenin bir özelliğidir. Örnek olarak boyut (dimension), özellik (feature, characteristic) olarak da

kullanılırç Nitelikler ve niteliklere ait değerler bir nesneyi oluşturur. Uygulamalarda toplanan veri

yetersiz, tutarsız ya da gürültülü olabilir. Hata sebepleri:

•

•

•

•

•

•

Hatalı veri toplama gereçleri

Veri giriş problemleri

Veri girişi sırasında kullanıcıların hatalı yorumları

Veri iletim hataları

Teknolojik sınırlamalar

Veri isimlendirmede veya yapısında uyumsuzluk

•

•

•

•

•

•

•

•

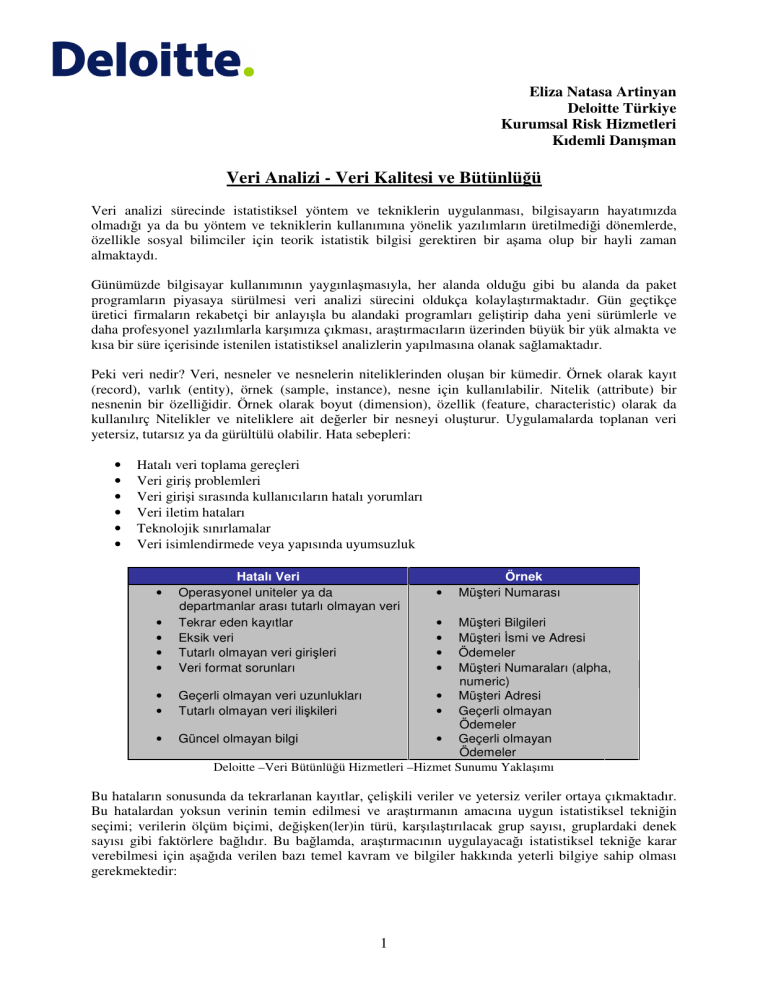

Hatalı Veri

Operasyonel uniteler ya da

departmanlar arası tutarlı olmayan veri

Tekrar eden kayıtlar

Eksik veri

Tutarlı olmayan veri girişleri

Veri format sorunları

•

Örnek

Müşteri Numarası

Müşteri Bilgileri

Müşteri İsmi ve Adresi

Ödemeler

Müşteri Numaraları (alpha,

numeric)

Geçerli olmayan veri uzunlukları

• Müşteri Adresi

Tutarlı olmayan veri ilişkileri

• Geçerli olmayan

Ödemeler

Güncel olmayan bilgi

• Geçerli olmayan

Ödemeler

Deloitte –Veri Bütünlüğü Hizmetleri –Hizmet Sunumu Yaklaşımı

•

•

•

•

Bu hataların sonusunda da tekrarlanan kayıtlar, çelişkili veriler ve yetersiz veriler ortaya çıkmaktadır.

Bu hatalardan yoksun verinin temin edilmesi ve araştırmanın amacına uygun istatistiksel tekniğin

seçimi; verilerin ölçüm biçimi, değişken(ler)in türü, karşılaştırılacak grup sayısı, gruplardaki denek

sayısı gibi faktörlere bağlıdır. Bu bağlamda, araştırmacının uygulayacağı istatistiksel tekniğe karar

verebilmesi için aşağıda verilen bazı temel kavram ve bilgiler hakkında yeterli bilgiye sahip olması

gerekmektedir:

1

•

•

•

•

•

•

•

•

•

İstatistik

Veri

Seri

Frekans

İstatistiksel anlamlılık

İstatistiksel hipotez

Değişken

Ölçek Çeşitleri

Veri Analizinde Kullanılacak İstatistiksel Teknikler

Denetim ve danışmanlık dünyasında veri analizinin yeri çok farklıdır. Günümüzde verilerin büyük

hacimlere ulaşması ve bunun daha kısa süreler içinde katlanarak artması ve karmaşıklaşması,

çalışmalarımızda daha kapsamlı ancak kolay kullanılabilen ve yenilenen teknolojilerle uyumlu

yazılımlara duyulan gereksinimi de artırmaktadır. Daha büyük veri kaynaklarından hemen her

formatta veri okuyabilen, en gelişmiş veri analizi tekniklerini barındıran, hızlı ve doğru analizlerle

ayrıntılı ve çok çeşitli grafikler ve raporlar üretebilen yazılımların istediğimiz sonuçlara kolaylıkla

ulaşmamızda çok büyük yardımları olmaktadır.

Veri analizi süreci, bilimsel araştırma sürecinin en önemli basamaklarından biridir. Bu süreçte

toplanılan veriler amaca uygun istatistiksel teknikler ile işlenir veya analiz edilir. Son zamanlarda

şirketler etkinlik ve verimliliklerini artırabilmek ve karar mekanizmalarını güçlendirebilmek için veri

kalitesi ve bütünlüğüne verdikleri değeri ve zamanı artırmaktadır. Bunun nedeni, veri kalitesi ve

bütünlüğünün firmalara katmakta olduğu değerin farkındalık yaratmasıdır. Veri kalitesi ve

bütünlüğünün sağlayacağı değerler/faydalar aşağıdaki şekilde özetlenmektedir: Veri Analizi Eğitimi,

Veri Kalitesi Kontrolü, Gelir Güvencesi, Veri Analizi ve Değerlendirmesi, SAS 99/Fraud Analizleri

ve Maliyet Düşürme.

Veri Kalitesi ve Bütünlüğü Servisleri

Deloitte –Veri Kalitesi ve Bütünlüğü – İç Denetim

Tüm dünyada bilgi yanlışlığının veya eksikliğinin yol açacağı risklerin tespiti, birden fazla sistemin

birleşmesi, bilgi düzeltilmesine ihtiyaç duyulması ve eksik bilginin tamamlanması gibi konularda veri

analizi süreci devreye girmektedir. Peki Türkiye’de hangi şirketler veri kalitesi ve bütünlüğü

çalışmalarına ihtiyaç duymaktadır?

2

•

•

•

Büyük kapasitelerde arşiv bilgisine sahip olanlar,

Kompleks yapılara sahip olanlar,

Büyük rakamlarda müşteri sayısına sahip olanlar.

Bu şirketler Veri Kalitesi ve Bütünlüğü konusunda kendilerini nasıl geliştirebilir ya da hangi

konularda destek alabilir?

Günümüzde Veri Kalitesi ve Bütünlüğü hizmetleri aslında 5 ana başlık çerçevesinde toparlanabilir :

Veri Doğrulama (Data Validation), Veri Madenciliği (Data Mining), Veri Temizleme (Data

Cleansing), Veri Optimizasyonu (Data Optimization) ve son olarak Kontrollerin İzlenmesi/Takibi

(Monitoring Controls). Fakat bunların ayrı ayrı kullanılmalarının söz konusu olduğu gibi projenin

yapısına ve büyüklüğüne bağlı olarak da birlikte kullanılmaları da mümkündür.

Veri Doğrulama (Data Validation)

Şirketler yeniden yapılanma ya da varolan sistemlerinde değişiklik yaratıp daha yeni ve kolay

kullanılabilen sistemler ya da veriler yaratabilmek için inanılmaz çok zaman ve para harcamaktadır.

Fakat bu noktada her yeni sistem uygulamasında ya da veri geçişinde verinin bozulma ihtimali

olduğunu unutmamak gerekiyor. Kısaca, her yeni sistem değişikliği aslında bir risk doğurmakta ve

veri doğrulama işlemine gereksinimi artırmaktadır. Dolayısı ile kurumların da bu yeni sistemlerin

doğruluğunu ve verinin bütünlüğünü teyit etmeleri gerekmektedir.

Veri Madenciliği (Data Mining)

Veri madenciliği, büyük ölçekli veriler arasından bilgiye ulaşma işi ya da bir anlamda büyük veri

yığınları içerisinden gelecek ile ilgili tahminde bulunabilmemizi sağlayabilecek bağıntıların bilgisayar

programı kullanarak aranmasıdır. Borç veren, devralıcı ya da resmi kurumlar tarafından açığa çıkarılan

finansal verinin bağımsız tahminleri çok çabuk istenmektedir ve bu da çok büyük olan bir verinin

acilen incelenmesini gerektirmektedir. Veri madenciliği sorgu işleme (sonuçç çıkarıma yönelik) ya da

uzman sistemler veya küçük istatistiksel programlar değildir. Veri madenciliği aslında bilgi keşfi

sürecinin bir parçası şeklinde kabul görmektedir. Bu adımlar:

•

•

•

•

•

•

•

Veri Temizleme (gürültülü ve tutarsız verileri çıkarmak)

Veri Bütünleştirme (birçok veri kaynağını birleştirebilmek)

Veri Seçme (Yapılacak olan analiz ile ilgili olan verileri belirlemek)

Veri Dönüşümü

(Verinin veri madenciliği tekniğinden kullanılabilecek hale

dönüşümünü gerçekleştirmek)

Veri Madenciliği (Veri örüntülerini yakalayabilmek için akıllı metotları uygulamak)

Örüntü Değerlendirme (Bazı ölçümlere göre elde edilmiş bilgiyi temsil eden ilginç

örüntüleri tanımlamak)

Bilgi Sunumu (Madenciliği yapılmış olan elde edilmiş bilginin kullanıcıya sunumunu

gerçekleştirmek)

Anlamlı ve güvenilir bilginin çabuk ve doğru bir şekilde edinebilmesi için, veri analizi ve istatistiksel

örnekleme deneyiminin birleştirilmesi gerekmektedir. Ancak bu şekilde istatistiksel doğruluğu

kanıtlanmış veriye ulaşılabilir.

Günümüzde şirketlerin iş ve stratejik karar alma süreçlerinde en büyük gereksinimlerden biri de, sahip

oldukları ham veriyi işleyerek yeni bilgi, fırsat ve aksiyonlar üretmek; ürettikleri bilgiyi piyasa

ihtiyaçlarına yanıt verecek biçimde kullanmaktır. Veri Madenciliği; finans, bankacılık, perakende,

sigorta, telekomünikasyon başta olmak üzere pek çok sektörde, şirketlerin veritabanları ya da veri

ambarlarında bulunan verilerden geleceğe yönelik tahminler, modeller elde etmeye olanak

sağlamaktadır. Veri Madenciliği yöntemleri ile şirketler, çok büyük veri yığınlarından önceden

3

bilinmeyen, geçerli ve uygulanabilir değerli bilgiyi kısa sürede elde ederek önemli rekabet avantajları

(gelirlerde artış, maliyetlerde düşüş ve yetkin bir piyasa farkındalığı...) sağlayabilmektedir. Dünyanın

önde gelen firmaları, veri madenciliği tekniklerini; müşteri ilişkileri yönetiminden, kredi

derecelendirmeye; risk analizinden, satış tahminlerine kadar pek çok alanda başarıyla

kullanmaktadırlar. Veri madenciliğinde aşağıdaki teknikler uygulanmaktadır:

•

•

•

•

•

Yapay sinir ağları

Genetik algoritmalar

İstatistik kökenli yöntemler

Kural eldesi algoritmaları ve karar ağaçları

Veri görselleştirme

Yapay Sinir

Ağları

Yapılandırma

Kolaylığı

Esneklik

Otonomi

Hesaplama

Karmaşası

Açıklayabilirlik

İstatistik

Kural Eldesi

Genetik

Kökenli

ve Karar

Veri

Algoritmalar Yöntemler Ağaçları

Görselleştirme

Düşük

Çok Düşük

Yüksek

Çok Yüksek

Orta

Yüksek

Yüksek

Orta

Yüksek

Orta

Düşük

Düşük

Düşük

Düşük

Çok Yüksek

Çok Yüksek

Çok Yüksek

Orta

Düşük

Çok Yüksek

Çok Düşük

Yüksek

Orta

Çok Yüksek

Deloitte –Veri Madenciliği Teknikleri

Çok Yüksek

Veri Temizleme (Data Cleansing)

Veri analizi işlemini gerçekleştimenin öncesinde veri temizliği yapmak gerekmektedir. Bu adım çok

kritiktir ve veri analizi sürecinin başarılı ya da başarısız olmasında bir anahtar işlevi görmektedir.

Öncelikle verilerin gerçek süreçleri ve değişiklikleri yansıtacak bir biçimde hazırlanması

gerekmektedir. Tipik olarak, veri temizleme uyumsuz ve tamamlanmamış kayıtların ortaya

çıkarılmasını içerir. Uyumsuz kayıtlar, tipik değerlerden önemli ölçüde farklı olan değerlerdir.

Tamamlanmamış kayıtlar ise, veri giriş sistemlerindeki hataların sonuçları olabilir. Hatalı ya da

tamamlanmamış veriler bir kere tepit edildiğinde, analizden çıkarılmalı ya da düzeltilmelidir.

Gerçek uygulamalarda veri eksik, gürültülü veya tutarsız olabilir. Veri temizleme işlemleri eksik

nitelik değerlerini tamamlama, aykırılıkların bulunması ve gürültülü verinin düzeltilmesi ve

tutarsızlıkların giderilmesini içermektedir. Veri için bazı niteliklerin değerleri her zaman

bilinmeyebilir, buna eksik veri adı verilir. Eksik veri diğer veri kayıtlarıyla tutarsızlığı nedeniyle

silinmesi, bazı nitelik değerleri hatalı olması dolayısıyla silinmesi, yanlış anlama sonucu

kaydedilmeme ve veri girişi sırasında bazı nitelikleri önemsiz göre sonucunda ortaya çıkabilir. Eksik

verinin tamamlanabilinmesi için aşağıdaki adımlar uygulanabilir:

•

•

•

•

•

•

Eksik nitelik değerleri olan veri kayıtlatını kullanma

Eksik nitelik değerlerini manuel olarak doldurma

Eksik nitelik değerleri için global bir değişken kullanma (null, bilinmiyor...)

Eksik nitelik değerlerini o niteliğin ortalama değeri ile doldurma

Aynı sınıfa ait kayıtların nitelik değerlerinin ortalaması ile doldurma

Olasılığı en fazla olan nitelik değeriyle doldurma

Gürültülü veri ise, ölçülen bir değerdeki hatadan kaynaklanır. Yanlış nitelik değerleri hatalı veri

toplama gereçleri, veri giri problemleri, veri iletimi problemleri, teknolojik kısıtlar ve nitelik

4

isimlerinde ki tutarsızlıktan meydana gelebilir. Gürültülü verinin düzeltilebilmesi için aşağıdaki

adımlar uygulanabilir:

•

•

•

Bölmeleme (veri sıralanır, eşit eşitlik veya eşit derinlik ile bölünür)

Demetleme (aykırılıkları belirler)

Eğri uydurma (veriyi fonksiyona uydurarak gürültüyü düzeltir)

Veri Temizleme metodu sonucunda ERP ve ebusiness çalışmaları için kesin ve uygulanabilir fayda

sağlanmaktadır. Ayrıca Veri Optimizasyonu ile de ek faydalar elde edilebilir:

Veri Temizleme Faydaları

Veri Optimizasyonu Faydaları

•

•

SAP'e temiz geçiş

Sistem entegrasyonu ve yazılım

uygulamaları sonucu ortaya çıkan katma

değer

•

E-business'a geçiş sürecindeki başarı

•

Gelişmiş müşteri servisi ve memnuniyeti

•

•

Potensiyel risk seviyesinde azalma

Temiz veri sonucu elde edilen rekabetçi

üstünlük

Deloitte –Veri Bütünlüğü Hizmetleri –Hizmet Sunumu Yaklaşımı

•

•

•

•

•

Gelişmiş Nakit Akışı

Organizasyondaki sonuç odaklı

departmanlara daha çok kaynak ve zaman

ayrılması

Stratejik kararları etkileyen analizlerin

iyileştirilmesi

Organizasyon içerisindeki gelişmiş ilişkiler

Müşteri ve tedarikçi tarafında risklerin

azalması

Veri Optimizasyonu (Data Optimization)

Veri işleme ve veri işlemenin eniyilenmesi (optimizasyonu) yönetsel yapılarda büyük önem kazanır.

Büyük tutarlarda verinin işlenmesi, zamansal kısıtlar nedeniyle, genellikle, eniyileme gerektirir.

Bu noktada, Veri Temizleme (Data Cleansing) ve Veri Optimizasyonu’nun (Data Optimization)

benzerliklerini ve farklılıklarını çok iyi anlamak gerekmektedir. Veri Temizleme işlemi kesinlikle veri

optimizasyonundan önce gerçekleştirilmelidir, çünkü ancak temiz veri ile güvenilir veri analizi

sonucuna ulaşılabilir. Bunun yanında ise, aşağıdaki şekilden de anlaşılabileceği gibi Veri Temizleme

ve Veri Optimizasyonu’nun güçlü yanları ele alınarak, ikisini birlikte kullanmak Proje

Sürecini/Döngüsünü daha güçlü bir hale getirmektedir:

Proje Süreci/Döngüsü

Deloitte –Veri Bütünlüğü Hizmetleri –Hizmet Sunumu Yaklaşımı

5

Kontrollerin İzlenmesi/Takibi (Monitoring Controls)

Prosedür ve kontroller otomize olduğu sürece, bilginin doğruluğunu teyit etmek amacı ile üst yönetim

ya da bağımsız gözden geçirmeye duyulan ihtiyaç artmaktadır. Aksi takdirde üst yönetim veri

doğruluğu ve bütünlüğünden emin olamaz. Bu durumda da veri örneklemesi ve analizi yardımı ile

düzenli özet istatistikler önem kazanmaktadır.

Geçmişe yönelik veri saklayan sistemlerdeki verinin kalitesini ve günümüz koşullarındaki işe

yararlılığını ölçmeyi ve artırmayı, anlamlı hale gelmesini sağlamayı ve şirketlerin hızlı ve esnek

raporlama gereksinimlerini karşılamayı hedefleyen veri kalitesi ve bütünlüğü konusu son günlerde tüm

dünyada olduğu gibi Türkiye’de de ilgi çekmeye ve önem kazanmaya başlamıştır. Bu fonksiyonun

gerçekleşmesi için özel yazılımlar kullanılmakta, çeşitli istatistiksel metotlar ile verilerin analizi

gerçekleştirilmektedir. Denetim ve danışmanlık dünyasında da veri kalitesi ve bütünlüğü kapsamında,

uygulamalardaki veriler firmaların talepleri doğrultusunda düzeltilmekte veya yeniden sisteme

girilmektedir.

Zaman içerisinde bütün sistemlerin özelliklerinde ve dolayısıyla ürettikleri verilerde ortaya çıkan

değişiklikler, kurulan modellerin sürekli olarak izlenmesini ve gerekiyorsa yeniden düzenlenmesini

gerektirmektedir. Tahmin edilen ve gözlenen değişkenler arasındaki farklılığı gösteren grafikler model

sonuçlarının izlenmesinde kullanılan yararlı bir yöntemdir.

6

Kaynaklar:

Ann Thornton and Sheri Redokovitz from Deloitte & Touche. “Data Quality and Integrity –

Analysis & Estimation“, February 2008

Bilimsel Araştırma Süreci ve SSPS ile Veri Analizi, Kasım 2008

Frelinger, Bob. “ISACA to Offer New IT Governance Credential”, Vol.2, July 2007

Timothy Krick and Gregory Elmore from Deloitte & Touche. “Data Quality and Integrity

(DQI) Internal Audit“, March 2008

Vikipedia Özgür Ansiklopedi. “Veri Madenciliği”, Kasım 2008

Rowsell-Jones, Andrew. “Finding success with standards”, CIO Canada, Dec 2006

Infora Advanced Analytical Solutions – Veri Temizleme, Kasım 2008

Rasmussen, Michael. “Taking Control of IT Risk”, Forrester Research, 2005

Hughes, Greg. “IT Risk Management Report”, Symantec Corporation, Vol. 1, February 2007

Yrd. Doç. Dr. Şule Gündüz Öğüdücü. “Veri Madenciliği – Veri Önişleme”, Ekim 2008

Ali Alkan. “Finansal Uygulamalarda Veri Madenciliği”, 8 Haziran 2007

2. Uluslararası Kalite Organizasyonları ve Profesyonelleri Zirvesi. “Kalite İyileştirmede Veri

Madenciliği Yaklaşımları ve Uygulamaları, 12 Kasım 2007

7