6. Ders - 80.251.40.59

advertisement

6. Ders

Bu derste gerekli olacak bazı ön bilgileri hatırlatalım:

* Karesel ve lineer formların türevleri

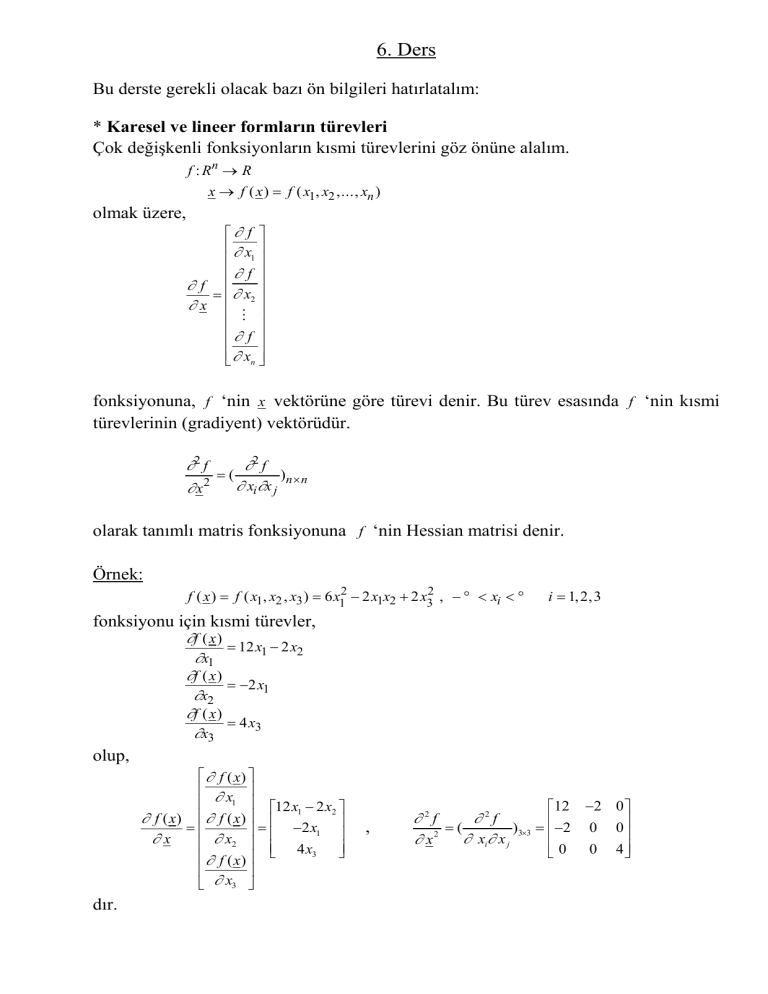

Çok değişkenli fonksiyonların kısmi türevlerini göz önüne alalım.

f : Rn → R

x → f ( x ) = f ( x1, x2 ,..., xn )

olmak üzere,

∂ f

∂ x

1

∂ f

∂f

= ∂ x2

∂x

⋮

∂ f

∂ xn

fonksiyonuna, f ‘nin x vektörüne göre türevi denir. Bu türev esasında f ‘nin kısmi

türevlerinin (gradiyent) vektörüdür.

∂2 f

∂2 f

=

(

)

∂ xi ∂x j n × n

∂ x2

olarak tanımlı matris fonksiyonuna f ‘nin Hessian matrisi denir.

Örnek:

f ( x ) = f ( x1, x2 , x3 ) = 6 x12 − 2 x1x2 + 2 x32 , − ∞ < xi < ∞

i = 1, 2 , 3

fonksiyonu için kısmi türevler,

∂f ( x )

= 12 x1 − 2 x2

∂x1

∂f ( x )

= −2 x1

∂x2

∂f ( x )

= 4 x3

∂x3

olup,

∂ f ( x)

∂ x1 12 x1 − 2 x2

∂ f ( x) ∂ f ( x)

=

= −2 x1

∂x

∂ x2 4 x

3

∂ f ( x)

∂ x3

dır.

12

,

∂2f

∂2f

=

(

)3×3 = −2

2

∂ xi∂ x j

∂x

0

−2 0

0 0

0 4

* a: n × 1

sabitlerin bir vektörü olmak üzere,

∂ ( a ′ x ) ∂ ( x ′a )

∂ 2 (a ′ x)

=

=a ,

=0

∂x

∂x

∂ x2

dır.

1

Örnek: a = 2

−3

,

x1

x = x2

x3

,

a ' x = x1 + 2 x2 − 3x3 ,

∂ ( a ' x)

∂ x1 1

∂ ( a ' x) ∂ ( a ' x)

=

=2=a

x

∂x

∂

2

− 3

∂ ( a ' x)

∂ x3

* A: n × n tipinde simetrik bir matris olmak üzere

∂( x' A x )

∂2 ( x' A x)

= 2 Ax,

= 2A

∂x

∂x2

dır.

Örnek: f ( x1 , x 2 , x3 ) = x12 + 2 x 22 − 2 x1 x 2 + x1 x3 − 4 x 2 x3 karesel formu matris gösterimi ile

1

1 −1 2

A = −1 2 −2

1

−2 0

2

olmak üzere,

1

1 −1 2 x1

f ( x) = x′Ax = [ x1 x2 x3 ] −1 2 −2 x2 = x12 + 2 x22 − 2 x1x2 + x1x3 − 4 x2 x3

1

x

−2 0 3

2

biçiminde yazılıp x e göre türevi alınırsa,

1 −1 1/ 2 x1 2 x1 − 2 x2 + x3

∂ f ( x)

= 2 A x = 2 −1 2 −2 x2 = −2 x1 + 4 x2 − 4 x3

∂ x

1/ 2 −2 0 x3

x1 − 4 x2

elde edilir.

2 x1 − 2 x2 + x3

∂ f ( x)

= −2 x1 + 4 x2 − 4 x3

∂ x

x1 − 4 x2

vektörü, f fonksiyonunun kısmi türevlerinin vektörüdür.

2

∂2f

∂2f

=(

)3×3 = −2

2

∂ xi∂ x j

∂x

1

−2

1

4 −4

−4 0

olmak üzere bu, f fonksiyonunun ikinci mertebeden kismi türevlerinin matrisidir.

Örnek:

olsun.

Y : n × 1 bir vektör X : n × p tipinde bir matris ve β: p ×1 tipinde bir vektör

f (β) = Y − X β

2

= (Y − X β ) ′ ( Y − X β )

ifadesinin β ya göre türevi,

f ( β ) = ( Y − X β ) ′ (Y − X β )

= ( Y ′ − β′ X ′ )( Y − X β )

= Y ′ Y − Y ′ X β − β′ X ′ Y + β′ X ′X β

Y ′ X β ve β′ X ′ Y , 1 × 1 boyutlu olduklarından,

Y ′ X β = ( Y ′ X β ) ′ = β′ X ′ Y

olmak üzere,

ve

f ( β ) = Y ′ Y − 2 β′ X ′ Y + β′ X ′X β

∂f (β)

= −2 X ′Y + 2 X ′X β

∂β

dır. Bu türevi sıfıra eşitlersek,

X ′X β = X ′Y

denklemi elde edilir. Bu denklemin çözümü olan β vektörleri f (β) fonksiyonunun

ekstremum noktalarıdır.

∂ 2 f (β )

∂β2

= 2 X ′X

olup, X ′X matrisi pozitif tanımlı olduğundan

X ′X βˆ = X ′Y

olacak şekilde β̂ çözümü için f ( βˆ ) minimum değerini almaktadır, yani

min(Y − X β )′(Y − X β ) = (Y − X βˆ )′(Y − X βˆ )

β

dır.

Karesel formların beklenen değerleri

Y : n × 1 boyutlu ve A : n × n simetrik bir matris olmak üzere bir rasgele vektör olmak

üzere,

′

E (Y AY ) = tr [ACov(Y )] + E (Y )′ AE (Y )

ve Cov(Y ) = σ 2 I ve E (Y ) = 0 ise E (Y ′ AY ) = σ 2 tr ( A) dır.

Bağımsızlık (normal dağılımlı rasgele vektörlerin lineer ve karesel formları)

* Y ∼ N ( µ , Σ n×n ) , rank (Σ) = n olmak üzere,

AY ile Y ′ BY bağumsız ⇔ A Σ B = 0

dır.

* Y ∼ N ( µ , Σ n×n ) , rank (Σ) = n olmak üzere,

Y ′ BY ile Y ′CY bağımsız ⇔ BΣC = 0

dır.

Çoklu Lineer Regresyon Modelleri

(Çok Açıklayıcı Değişkenli Lineer Regresyon Modelleri)

Konuya geçmeden önce Basit Doğrusal Regresyon Modeli ile ilgili bir örneği

göz önüne alalım.

Örnek: Belli bir tür elmadaki meyve suyu miktarını, elmanın ağırlığına bağlı olarak

incelemeyi düşünelim. Gerçekte, bir elmadaki meyve suyu miktarı sadece elmanın

ağırlığına bağlı değildir, ama ağırlık ile meyve suyu arasında bir bağıntının varlığını

kabul edip gözlemlerin bunu doğrulayıp doğrulamadığını, gözlemlerden çıkıp bir

bağıntının bulunmasını ve bunların neticesinde ağırlığa bağlı olarak meyve suyu

miktarını belirlemeyi (tahmin etmeyi) düşünebiliriz. Bu örnekteki açıklayıcı değişken

olan elmanın ağırlığı ve açıklanan (bağımlı) değişken olan elmadaki meyve suyu

miktarı birer rasgele değişkendir. Ağırlığı X , meyve suyu miktarını Y ile gösterirsek

X ile Y ‘nin bir ortak dağılımı söz konusu olacaktır.

E (Y / X = x ) = g ( x )

ifadesine Y nin X üzerindeki regresyon fonksiyonu (regresyon bağıntısı, regresyon

denklemi) dendiğini ve X ile Y ‘nin ortak dağılımı normal olduğunda,

E (Y / X = x ) = β0 + β1x

biçiminde olduğunu hatırlatalım. ( X , Y ) ‘nin dağılımından n birimlik örneklem,

( X1, Y1), ( X 2 , Y2 ),..., ( X n , Yn ) olmak üzere,

Yi = β 0 + β1xi + ε i , i = 1, 2,..., n

,

ε i ∼ N (0,σ 2 ), ε i 'ler bağımsız

veya matris gösterimi ile

Y1

1 x1

ε1

Y

1 x

ε

β0

2

Y = 2 , X =

, β = , ε = 2

⋮

⋮ ⋮

⋮

β1

Yn

1 xn

ε n

Y = X β + ε , ε ∼ N (0, σ 2 I )

yazabiliriz. Elmanın ağırlığı ( X ) ile elmadaki meyve suyu miktarı Y ‘nin ortak

dağılımı normal olmayabilir. Bu durumda da,

E (Y / X = x ) = β0 + β1x

ve

Yi = β 0 + β 1 xi + ε i , i = 1,2,..., n , E(ε i ) = 0 , Var (ε i ) = σ 2 , ε i 'ler bağımsız/ilişkisiz

biçiminde bir Basit Doğrusal Regreson Modeli söz konusu olabilir.

Amacımız, seçilen bir elma için X ‘in gözlenen değerine bağlı olarak Y ‘nin

değerini tahmin etmek veya X = x olan elmaların koşullu ortalamasını (beklenen

değerini) tahmin etmek olabilir.

Çok Açıklayıcı Değişkenli Lineer Regresyon Modeli kavramını bir örnek ile

açıklamaya çalışalım.

Örnek: Belli bir mısır türünün verimini incelemeyi düşünelim. Verim, toprak ve

hava ile ilgili birçok tabiat şartı yanında sulama, gübreleme, toprağı işleme gibi bazı

etkenlere bağlıdır. Çok karmaşık olan gerçek dünyadaki ilişkilerden bazılarını ihmal

ederek, verim ( Y ) için toplam yağış miktarına ( X1 kg / m2 ) , sıcaklık ortalamasına

( X 2 oC , bitkinin yetişmesi boyunca her gün bir defa ölçülen sıcaklıkların ortalaması),

gübre miktarına ( X 3 kg / m 2 ) , bir metrekaredeki bitki sayısına ( X 4 ) bağlı olarak,

E (Y / X 1 = x1 , X 2 = x2 , X 3 = x3 , X 4 = x4 ) = β 0 + β1 x1 + β 2 x2 + β3 x3 + β 4 x4

gibi bir regresyon fonksiyonu ve gözlemler için,

Yi = β 0 + β1x1i + β 2 x2i + β3 x3i + β 4 x4i + ε i , i = 1, 2,..., n

gibi bir modelin geçerli olduğunu düşünebiliriz.

Y1

1

Y

1

2

Y=

, X=

⋮

⋮

Yn

1

x11

x21

x31

x12

⋮

x1n

x22

⋮

x2 n

x32

⋮

x3n

β0

x41

ε1

β

1

ε

x42

, β = β2 , ε = 2

⋮

⋮

β3

x4 n

ε n

β 4

gösterimleri altında, bu model

Y = Xβ + ε

biçiminde yazılabilir. Gerçek dünyadaki olguların modellenmesi sırasında Y , X, β ‘nın

modellenen olguya bağlı olarak kendine göre anlamları vardır. Bazı modellerde

bağımlı değişken ( Y ) milli gelir, açıklayıcı değişkenler sanayi yatırımı ( X 1 ), sanayi

destekleme kredisi ( X 2 ), tarım yatırımı ( X 3 ), tarım destekleme kredisi ( X 4 ), kamu

harcamaları ( X 5 ) gibi değişkenler olabilir. Örneğin, ağırlık için açıklayıcı değişken

olarak boy uzunluğu, kol uzunluğu, omuz çevresi, kalça çevresi gibi değişkenler göz

önüne alınabilir.

Y gerçek dünyada bir olgu ile ilgili bir özellik üzerinde yapılan n tane gözlemin

oluşturduğu vektör ( n × 1 mertebeli vektör, rasgele vektör); X : n × p (n > p) açıklayıcı

değişkenler ile ilgili gözlenen ya da tasarlanan matris (sabit sayıların matrisi); β : p ×1

bilinmeyen parametrelerin vektörü; ε : n×1 gözlenemeyen hata vektörü (rasgele

vektör) olmak üzere, bunlar arasında,

Y = Xβ + ε

, E (ε ) = 0 , Cov(ε ) = Σ

biçiminde varsayılan bağıntıya lineer model denir. Lineer Regresyon Modellerinde,

E (Y / X 1 = x1, X 2 = x2 ,..., X p = xk ) = β 0 + β1x1 + β 2 x2 + ... + β k xk

gibi bir regresyon bağıntısının varlığı öncelik taşımaktadır.

Y = X β + ε lineer modelinde X β ‘ya modelin deterministik veya sistematik

kısmı, Y ve ε ‘a da modelin stokastik kısmı denir. X matrisine tasarım matrisi,

açıklayıcı değişkenlerin gözlem matrisi, bağımlı değişkenlerin gözlem matrisi gibi

isimler verilmektedir. X matrisinin birinci sütunu bir’lerden oluştuğunda β parametre

vektörünün birinci bileşeni β0 ile gösterilmekte ve sabit terim (intercept) ismini

taşımaktadır.

Lineer Regresyon Modelleri veya genel olarak Lineer Modeller pek çok özel

hallere sahiptir. Bunlar, ε ‘nun dağılımına, Σ kovaryans matrisine, X in yapısına ve

rankına bağlıdır.

olduğunu kabul edeceğiz, yani

Aksi belirtilmedikçe, rank ( X) = p

modelimizdeki X matrisi tam sütun ranklı olacaktır. ε ‘nun dağılımı hakkında

aşağıdaki üç durumu göz önüne alacağız:

1.Durum : ε ∼ N (0, σ 2I)

2.Durum: ε bilinmeyen bir dağılıma sahiptir ve E (ε ) = 0 , Cov(ε ) = σ 2I dır. Bu

durumu ε ∼ (0, σ 2I) biçiminde göstereceğiz.

3. Durum: Cov(ε ) = σ 2 V , V bilinen pozitif tanımlı bir matris.

Birinci durumda herbir εi , 0 ortalamalı bilinmeyen σ2 varyanslı normal dağılıma

sahiptir ve ε i (i = 1,2,..., n) ‘ler bağımsızdır. Đkinci durumda, herbir εi nin beklenen

değeri sıfır, εi ler ilişkisiz (uncorrelated) ve εi ler bilinmeyen aynı σ2 varyansına

sahiptirler.

Parametre Tahmini

Bu derste, Y = X β + ε Lineer Modelinde,

1.Durum : ε ∼ N (0, σ 2I)

2.Durum : ε ∼ (0, σ 2I)

3.Durum : Cov(ε ) = σ 2 V , V : bilinen bir matris

için parametre tahmini problemi ele alınacaktır.

1.Durum:

Y = X β + ε , ε ∼ N (0, σ 2I )

Bu durumda, Y ∼ N ( X β , σ 2I) olmak üzere,

σ2 ve β nın en çok olabilirlik

(maximum likelihood) tahmin edicilerini bulalım. Olabilirlik fonksiyonu,

L (β, σ ; Y ) =

2

1

−

1

2

e 2σ

n 2 n/ 2

( 2π ) (σ )

( Y − X β ) ′ (Y − X β )

ve logaritması,

n

n

1

ln L (β , σ2 ; Y ) = − ln( 2 π ) − ln( σ2 ) − 2 (Y − X β)′ (Y − X β)

2

2

2σ

n

n

1

= − ln( 2 π ) − ln( σ 2 ) −

( Y ′ Y − 2Y ′ X β + β ′ X ′X β )

2

2

2

2σ

dır. Parametre kümesi,

β1

β2

β

2

Θ = : β = , −∞ < βi < ∞ , i = 1, 2,..., p , σ > 0

σ 2

⋮

β

p

üzerinde L(β, σ2 ) veya ln L (β, σ2 ) fonksiyonunu maksimum yapan β ve σ2 ‘yi bulmak

için,

∂

1

(ln L (β, σ2 ; Y )) = − 2 ( −2 X ′Y + 2 X ′X β)

∂β

2σ

∂

n

1

(ln L (β, σ2 ; Y )) = − 2 +

(Y − X β)′ (Y − X β)

2

∂σ

2σ

2 ( σ2 )2

birinci türevlerin sıfıra eşitlenmesiyle,

1

( X ′Y − X ′X β ) = 0

σ 2

1

n

(Y − X β )′(Y − X β ) = 0

− 2 +

2 2

2

σ

2(

σ

)

R| X ′X β = X ′Y

S| σ2 = (Y − X β)′(Y − X β)

n

T

denklem sisteminin normal denklemler ismini taşıyan,

X ′X β = X ′Y

denkleminden,

βɶ = ( X ′X )−1 X ′Y

(rank ( X n× p ) = p )

ve ikinci denklemden,

σɶ 2 =

(Y − X βɶ )′(Y − X βɶ )

n

elde edilir. βɶ ve σɶ ’ye β ve σ2 ’nin en çok olabilirlik tahmin edicileri denir.

2

Tahmin Edicilerin Özellikleri

Yansızlık: ∀ β ∈ R p×1 için,

E ( βɶ ) = E (( X ′X ) −1 X ′Y )

= ( X ′X ) −1 X ′E (Y )

= ( X ′X ) −1 X ′E ( X β + ε ) = XX + β = β

= ( X ′X ) −1 X ′X β

=β

olmak üzere βɶ , β nın yansız tahmin edicisidir.

E (σɶ ) = E[

2

′

Y ( I − X ( X ′X )−1 X ′ ) Y

]=

1

′

E[Y ( I − X ( X ′X ) −1 X ′ ) Y ]

n

n

1

= tr ( I − X ( X ′X ) −1 X ′ ) σ 2 I + ( X β )′ ( I − X ( X ′X ) −1 X ′ ) ( X β )

n

1

= tr[σ 2 ( I − X ( X ′X )−1 X ′ )] + 0

n

1 2

n− p 2

= σ ( n − p) =

σ

n

n

olmak üzere σɶ 2 , σ2 için yansız bir tahmin edici değildir.

{

}

′

Y ( I − X ( X ′X ) −1 X ′ ) Y

n

2

σˆ =

σɶ =

n− p

n− p

2

için,

E (σˆ 2 ) = E (

n

n

σɶ 2 ) =

E (σɶ 2 ) = σ 2 , ∀σ 2 > 0

n− p

n− p

olduğundan σˆ 2 tahmin edicisi yansızdır. σˆ 2 tahmin edicisine yansızlık için düzeltilmiş

en çok olabilirlik tahmin edicisi denir. βɶ ‘yı da β̂ ile gösterelim. Bu gösterimler

altında En Çok Olabilirlik Tahmin Edicileri,

βˆ = ( X ′X ) −1 X ′Y

σˆ 2 =

Y '( I − X ( X ′X ) −1 X ′)Y

n− p

(yanlılığı düzeltilmiş)

dır.

Yeterlilik

β̂ ve σˆ 2 istatistiklerinin yeterli istatistik olduklarını göstermek için Y nin

olasılık yoğunluk fonksiyonunun, sadece βˆ , σˆ 2 , β , σ 2 ‘yi içeren bir fonksiyon ile sadece

Y yi içeren bir fonksiyonun çarpımı olarak yazılabileceğini göstermeye çalışalım.

f (Y ; β , σ2 ) =

1

−

1

2

e 2σ

n 2 n/ 2

( 2π ) (σ )

(Y − X β )′ (Y − X β )

ve

(Y − X β )′(Y − X β ) = (Y − X βˆ + X βˆ − X β )′(Y − X βˆ + X βˆ − X β )

= (Y − X βˆ )′(Y − X βˆ ) + ( βˆ − β )′ X ′X ( β − βˆ )

= (n − p )σˆ 2 + ( βˆ − β )′ X ′X ( β − βˆ )

olmak üzere,

f (Y ; β , σ ) =

2

1

(2πσ 2 ) n /2

−

e

1

( n − p )σˆ 2 + ( βˆ − β )′ X ′X ( β − βˆ )

2σ 2

= g ( βˆ , σˆ 2 , β , σ 2 )h(Y )

biçiminde yazılabilir, burada h(Y ) ≡ 1 dır. βˆ ve σˆ 2 yeterli istatistiklerdir. Bu

istatistiklerin tam (complete) istatistikler olduğu da gösterilebilir.

Not: Bu sayfayı atlayabilirsiniz.

Đnformasyon Matrisi

∂

1

(ln L(β , σ 2 ; Y )) = 2 X ′(Y − X β )

∂β

σ

∂

n

1

(ln L(β , σ 2 ; Y )) = − 2 + 4 (Y − X β )′(Y − X β )

2

∂σ

2σ

2σ

ve

∂2

1

(ln L(β , σ 2 ; Y )) = − 2 X ′X

∂β∂β '

σ

∂2

∂β∂σ

(ln L(β , σ 2 ; Y )) = −

2

∂2

2

∂σ ∂σ

2

(ln L(β , σ 2 ; Y )) =

1

2σ 4

n

2σ

4

X ′(Y − X β

−

1

σ6

(Y − X β )′(Y − X β )

olmak üzere,

(

I β, σ2

)

∂ 2

∂β∂β '

= E

∂ 2

∂σ 2∂β

∂β∂σ 2

2

∂

2

2

∂σ ∂σ

∂2

1

1

E − 2 X ′X

E − 4 X ′(Y − X β

2σ

σ

=

1

n

1

E −

X ′(Y − X β E 4 − 6 (Y − X β )′(Y − X β )

2σ 4

2σ

σ

1

2 X ′X

σ

=

0

0

n

2σ 4

dır. Buna göre, β parametre vektörünün yansız bir tahmin edicisinin varyanskovaryans matrisi için Rao-Cramer alt sınırı σ 2 ( X ′X )−1 dır.

Cov( βˆ ) = Cov ( ( X ′X ) −1 X ′Y ) = ( X ′X )−1 X ' Cov(Y ) X ( X ′X ) −1 = σ 2 ( X ′X ) −1

olup, βˆ = ( X ′X ) −1 X ′Y en çok olabilirlik tahmin edicisi etkin’dir. Bir λ ' β lineer

parametric fonksiyonun (LPF) yansız tahmin edicilerinin varyansı için Rao-Cramer alt

sınırı σ 2λ '( X ′X )−1λ olmak üzere,

( )

(

)

Var λ ' βˆ = Var λ '( X ′X )−1 X ′Y = λ '( X ′X )−1 X ′Cov(Y ) X ( X ′X )−1λ = σ 2λ '( X ′X )−1λ

olup, λ ' βˆ tahmin edicisi λ ' β için etkin’dir.

βˆ ve σˆ 2 Đle Đlgili Dağılımlar

Modelimiz,

Y = X β + ε , ε ∼ N ( 0, σ 2 I )

olmak üzere,

Y ∼ N ( X β, σ2 I )

dağılımlıdır. βˆ = ( X ′X ) −1 X ′Y olmak üzere, Y ‘nin lineer bir fonksiyonudur. Buna göre,

E ( βˆ ) = ( X ′X ) −1 X ′E (Y ) = ( X ′X ) −1 X ′X β = β

Cov( βˆ ) = ( X ′X ) −1 X ′Cov(Y )(( X ′X ) −1 X ′)′ = σ 2 ( X ′X ) −1

olup,

βˆ ∼ N ( β , σ 2 ( X ′X ) −1 )

ve

βˆi ∼ N ( βi , σ 2 cii ) , i = 1, 2,..., p

dağılımlıdır. Burada cii , ( X ′X ) −1 matrisinin i. köşegen elemanıdır.

σˆ 2 ile ilgili dağılım,

(n − p )σˆ 2

∼ χ (2n− p )

σ2

dır (ispatlanabilir).

β̂ ile σˆ 2 ‘nin Bağımsızlığı

βˆ = ( X ′X ) −1 X ′Y

,

σˆ 2 =

1

′

Y I − X ( X ′X ) −1 X ′ Y

n− p

olmak üzere,

( X ′X )−1 X ′(σ 2 I )[ I − X ( X ′X )−1 X ′] = σ 2 [( X ′X )−1 X ′ − ( X ′X ) −1 X ′X ( X ′X ) −1 X ′] = 0

olduğundan β̂ ile σˆ 2 bağımsızdır.

i = 1, 2 ,..., p için β̂ vektörünün bileşenleri için,

( βˆi − β i ) / σ cii

(n − p )σˆ 2

σ2

dır.

/(n − p )

=

( βˆi − β i )

∼ t( n − p )

σˆ cii

2.Durum Y = X β + ε , ε ∼ (0, σ 2I)

X 11

Y1

X

Y

21

2

Y n×1 =

, X=

⋮

⋮

Yn

X n1

X1p

β1

ε1

ε

⋯ X2p

β2

, rank ( X ) = p , β =

, ε = 2

⋮

⋮

⋮

⋯ X np

ε n

β p

n× p

X 12 ⋯

X 22

⋮

X n2

modelinde Y örneklem’inin (gözlem vektörü) dağılımı bilinmediğinde β ve σ2

parametreleri için en çok olabilirlik tahmin edicileri söz konusu değildir.

ε ' ε = (Y − X β ) ′ (Y − X β )

karesel formunu minimum yapan,

arg min (Y − X β ) '(Y − X β ) = βˆ

β ∈R p×1

vektörüne β

‘nın En Küçük Kareler (EKK) tahmin edicisi denir. Optimizasyon

probleminin çözülmesiyle,

βˆ = ( X ′X ) −1 X ′Y

olarak elde edilir.

σ2 için yansız bir tahmin edici,

′

Y ( I − XX + )Y (Y − X βˆ )′(Y − X βˆ )

σˆ =

=

n− p

n− p

2

dır. Bu tahmin ediciye alışılagelmiş olarak σ2 ‘nin en küçük kareler tahmin edicisi

denir.

β̂

ve σˆ 2 tahmin edicileri sırasıyla β ve σ2 için yansız tahmin ediciler olmak

üzere, bu tahmin edicilerin dağılımları hakkında küçük örneklemler için herhangi bir

şey söylenemez. Büyük örneklemler için (yani n → ∞ için) β̂ nın dağılımı yaklaşık

olarak β ortalama vektörü ve σˆ 2 ( X ′ X )−1 kovaryans matrisi ile normal dağılıma sahip

olduğu söylenebilir.

Đspatsız olarak Gauss-Markov Teoremini verelim.

Gauss-Markov Teoremi:

Y = X β + ε , E(ε) = 0 , Cov(ε) = σ 2 I , rank ( X n× p ) = p

modelinde ℓ′ β ‘nın en küçük varyanslı lineer yansız tahmin edicisi ℓ′ β̂ dır.

Λ : r × p için Λβ ‘nın en küçük kovaryans matrisli lineer yansız tahmin edicisi Λβ̂ dır.

Buradaki küçüklük sıralaması bir matris sıralamasıdır. Simetrik olan A ve B matrisleri

için

B − A pozitif tanımlı olduğunda A < B

B − A pozitif yarı-tanımlı olduğunda A ≤ B

densin. Buna Löwner sıralaması denir. Başka sıralamalar da tanımlanabilir.

Y = X β + ε , E(ε) = 0 , Cov(ε) = σ 2 I , rank ( X n× p ) = p

modelinde, ℓ′ β ‘nın en küçük varyanslı lineer yansız tahmin edicisi olan ℓ′ β̂ ‘ya en

iyi lineer yansız (best linear unbiased, BLU) tahmin edici denir.

Λβ ‘nın en iyi lineer yansız tahmin edicisi Λβ̂ dır. Λ = I alınırsa, β ‘nın en iyi

lineer yansız tahmin edicisi β̂ olur. β ‘nın EKK tahmin edicisi en iyi lineer yansız

tahmin edicidir (BLUE).

Not: Bu sayfayı atlayabilirsiniz.

3.Durum:

Y = X β + ε , ε ∼ N (0, σ 2V ) , rank ( X n× p ) = p

modelinde, Vn × n bilinen, pozitif tanımlı bir matris olsun. Vn × n matrisi, rank( Gn × n ) = n

olan bir G matrisi cinsinden,

V = G ′G

olarak ayrıştırılabilir. Modelin her iki tarafı soldan ( G′ ) −1 ile çarpılsın.

(G ′)−1Y = (G ′)−1 X β + (G ′)−1 ε

ve

Z = ( G′ ) −1Y ∼ N (( G′ ) −1 X β, σ2 I )

η = ( G ′ ) − 1 ε ∼ N ( 0, σ 2 I )

A = ( G ′ ) −1 X

olmak üzere, model

Z = Aβ + η

,

η ∼ N (0, σ 2 I )

olarak yazılabilir.

βˆ = ( A′A) −1 A′Z = ( X ′V −1 X ) −1 X ′V −1Y

σˆ =

2

Z ′ I − A( A′A) −1 A′ Z

n− p

=

Y ′ V −1 − V −1 X ( X ′V −1 X )−1 X ′V −1 Y

n− p

tahmin edicileri sırasıyla β ve σ2 için düzgün minimum varyanslı yansız (UMVU)

tahmin edicilerdir. Bunlara Aitken tahmin edicileri denir. Ayrıca,

βˆ ∼ N ( β , σ 2 ( X ′V −1 X ) −1 )

ve

(n − p )σˆ 2

σ

2

∼ χ (2n − p )

dağılımlıdır.

Y = X β + ε , E (ε) ∼ 0 , Cov(ε) = σ 2V , V pozitif tanımlı bilinen matris , rank ( X n×p ) = p

modelinde,

βˆ = ( A′A) −1 A′Z = ( X ′V −1 X ) −1 X ′V −1Y

tahmin edicisi β ‘nın en iyi lineer yansız (BLU) tahmin edicisidir. σ 2 için yansız bir

tahmin edici

σˆ =

2

dır.

Y ′ V −1 − V −1 X ( X ′V −1 X ) −1 X ′V −1 Y

n− p

Uygulama

1.

2.

>> y=[ 55

56

55

57

59

57

52

54

51

54] ;

>> X=[ 1

1

1

1

1

1

1

1

1

1

4.5

5.5

6

7.5

9

6.5

2.5

3.5

1

4] ;

>> betasapka=(X'*X)^(-1)*X'*y

betasapka=

50.0971

0.9806

>> sigmakaresapka=y'*(eye(10)-X*(X'*X)^(-1)*X')*y/(10-2)

sigmakaresapka =

0.3101

>> sigmakaresapka=(y-X*betasapka)'*(y-X*betasapka)/(10-2)

sigmakaresapka =

0.3101

>> regress(y,X)

ans =

50.0971

0.9806

>> help regress

B = REGRESS(Y,X) returns the vector B of regression coefficients in the linear model Y = X*B.

[B,BINT] = REGRESS(Y,X) returns a matrix BINT of 95% confidence intervals for B.

[B,BINT,R] = REGRESS(Y,X) returns a vector R of residuals.

[B,BINT,R,RINT] = REGRESS(Y,X) returns a matrix RINT of intervals that can be used to

diagnose outliers. If RINT(i,:) does not contain zero, then the i-th residual is larger than would be

expected, at the 5% significance level. This is evidence that the I-th observation is an outlier.

[B,BINT,R,RINT,STATS] = REGRESS(Y,X) returns a vector STATS containing, in the

following order, the R-square statistic, the F statistic and p value for the full model, and an estimate

of the error variance.

>> [sonuc1 sonuc2 sonuc3 sonuc4 sonuc5]=regress(y,X)

sonuc1 =

50.0971

0.9806

sonuc2 =

49.1146 51.0796

0.8017 1.1595

sonuc3 =

0.4903

0.5097

-0.9806

-0.4515

0.0777

0.5291

-0.5485

0.4709

-0.0777

-0.0194

sonuc4 =

-0.7362 1.7168

-0.7107 1.7301

-1.9444 -0.0168

-1.5971 0.6942

-0.9740 1.1293

-0.6545 1.7127

-1.6615 0.5644

-0.7313 1.6730

-1.1293 0.9740

-1.3075 1.2686

sonuc5 =

0.9523 159.7025

0.0000

0.3101

3. Yulaf bitkisinde ana sapta Tane Sayısı (Y) aşağıdaki değişkenler ile açıklanmak

istensin.

X1 - metre kare ( m2 ) de bitki sayısı

X 2 - bitkide kardeş sayısı (parsel ortalaması)

X 3 - ana sapta yaprak sayısı (parsel ortalaması)

X 4 - bayrak yaprağı (en uçta bulunan yaprak) uzunluğu (mm)

X 5 - bayrak yaprağı genişliği (mm)

X 6 - bitki boyu (cm)

X 7 - salkımdaki boğum sayısı (parsel ortalaması)

Y - ana sapta tane sayısı (parsel ortalaması)

Aşağıdaki verilerAnkara Üniversitesi Ziraat Fakültesi Tarla Bitkileri Bölümünde elde

edilmiş olup,

Dilek Güvenç, (1984) “Lineer Modellerde Parametre Tahmini ve Değişken

Seçimi”, Doktora Tezi, Ankara Üniversitesi, Fen Fakültesi, Matematik Bölümü.

çalışmasından alınmıştır.

24 ayrı parsel üzerinde gözlem yapılmış, ölçümler alınmış ve aşağıdaki veri ortaya çıkmıştır.

X1

X2

X3

X4

X5

X6

X7

Y

143 4,0

4,7

200,1 13,2 117,6 4,7

59,7

150 3,7

4,3

201,7 13,8 108,6 4,2

51,1

143 3,3

4,1

169,1 12,5 99,6 4,2

50,6

152 4,1

4,2

175,0 11,9 103,9 4,2

52,8

149 3,0

4,3

200,6 13,9 99,8 4,4

52,6

153 3,4

4,4

188,0 12,5 103,6 4,1

55,5

180 3,7

4,3

166,2 12,5 96,0 3,9

50,7

178 3,2

4,3

173,2 12,8 101,2 4,4

54,1

153 4,2

5,1

215,5 14,1 114,0 4,9

54,7

154 2,9

5,3

247,4 18,9 142,8 6,2

79,6

165 2,9

4,7

280,1 17,8 135,6 5,1

65,7

124 3,4

4,8

278,4 18,5 137,4 5,4

78,2

114 2,7

4,8

250,0 18,1 118,9 5,7

99,9

133 3,4

4,9

322,6 18,4 150,3 5,4

86,4

180 2,5

5,0

278,3 17,8 130,0 5,5

77,5

130 3,7

4,8

275,2 17,6 142,7 5,5

90,7

172 3,2

4,8

295,5 18,5 123,5 5,7

94,3

119 3,1

4,5

274,3 18,3 126,3 5,6

95,9

138 3,0

4,5

344,3 18,5 111,5 6,0

120,2

145 3,0

4,2

196,1 15,7 105,6 4,8

58,1

137 2,5

4,6

344,3 21,3 122,2 6,3

125,6

175 3,1

4,0

173,3 15,2 104,3 4,9

62,4

123 3,2

4,0

199,7 16,2 112,9 5,2

77,6

140 2,3

4,0

287,9 23,6 99,9 5,8

110,1

Model:

Yi = β 0 + β1 X1i + β 2 X 2i + β3 X 3i + β 4 X 4i + β5 X 5i + β 6 X 6i + β 7 X 7i + ε i , i = 1, 2,..., n

Varsayımlar: 1) E (ε i ) = 0 , Var (ε i ) = σ 2 ,

i = 1, 2,..., n

2) ε1 , ε 2 ,..., ε n ‘ler bağımsız

3) ε1 , ε 2 ,..., ε n ‘ler normal dağılımlı.

Minitab çıktısı:

Regression Analysis: Y versus X1; X2; X3; X4; X5; X6; X7

The regression equation is

Y = 19,7 - 0,133 X1 + 1,76 X2 - 10,8 X3 + 0,237 X4 - 0,83 X5 - 0,396 X6 + 23,9 X7